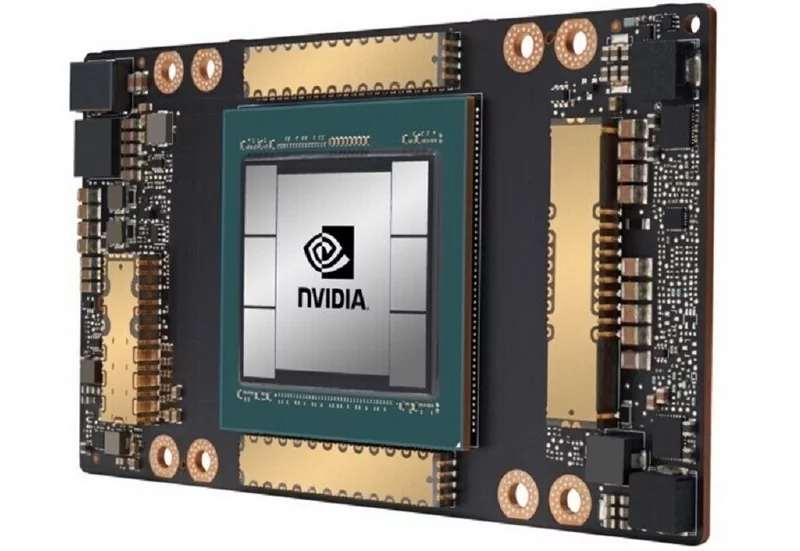

В конце 2022 года компания NVIDIA начала поставки ускорителей вычислений H800 и A800. По словам журналистов онлайн-издания TechPower Up, это аналоги моделей A100 и H100 с заниженным уровнем производительности. Таким образом, американская корпорация смогла наладить поставки своей продукции, не опасаясь попасть под санкционные ограничения.

Рост спроса на сложные нейронные языковые модели (LLM), такие как Generative Pre-trained Transformer (GPT), обусловлен стремительным развитием сферы искусственного интеллекта и в частности чат-ботов, которые умеют генерировать текст максимально похожий на человеческую речь. Именно для обучения нейронных сетей многие разработчики используют ускорители вычислени от компании NVIDIA.

Так, например, ускоритель A800 обеспечивает 70% мощности обычного A100. Производительность последнего в операциях FP64 составляет 9,7 Тфлопс, в задачах FP64 с использованием тензорных ядер — 19,5 Тфлопс, а в смешанных задачах FP16 и BF16 — до 624 Тфлопс. То есть при снижении производительности на 30%, ускоритель вычислений A800 будет обеспечивать производительность 6,8 Тфлопс в задачах FP64, 13,7 Тфлопс в аналогичных задачах, но уже с использованием тензорных ядер, и максимум 437 Тфлопс в смешанных задачах.

В Китае модель A800 можно приобрести за 100 000 юаней (~14 462 доллара США). Это не самый доступный ускоритель на территории Поднебесной. Информация о производительности H800 пока отсутствует.